[PYTHON] Maschinelles Lernen ⑤ AdaBoost-Zusammenfassung

Zusammenfassung von AdaBoost

Was ist AdaBoost?

Adaboost ist ein Modell für maschinelles Lernen, das versucht, einen starken Diskriminator zu erzeugen, indem schwache Diskriminatoren kombiniert werden, die etwas genauer als zufällig sind. Der Fluss, wie man macht Wenden Sie zunächst einen schwachen Diskriminator an und erhöhen Sie das Gewicht der falsch klassifizierten Personen. Dann werden diejenigen mit dem Gewicht priorisiert und klassifiziert. Ich wiederhole das.

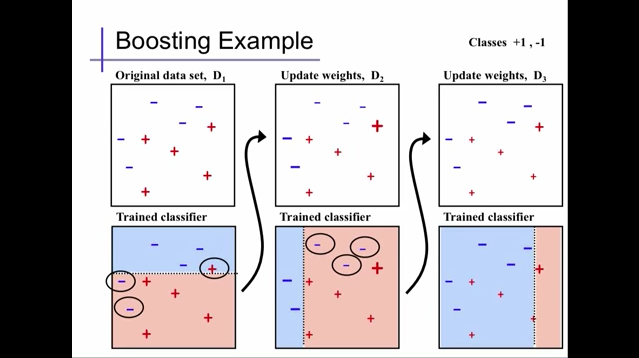

Es ist leicht zu verstehen, wenn Sie sich auf die folgende Abbildung beziehen. Ich habe auch einen Youtube-Link gepostet. Wenn Sie also mehr wissen möchten, schauen Sie bitte.

Extracted from Alexander Ihler's youtube video

Extracted from Alexander Ihler's youtube video

In der obigen Abbildung verwenden wir zuerst einen schwachen Diskriminator bei D1, um die Gewichte der durch D2 falsch klassifizierten '+' 1 und '-' 2 zu klassifizieren und dann zu erhöhen. Als nächstes werden die drei falsch klassifizierten Elemente priorisiert und erneut klassifiziert. Gleichzeitig mit der Gewichtszunahme nimmt hier das Gewicht anderer korrekt klassifizierter Personen ab. Darüber hinaus werden in D3 die Gewichte der in D2 falsch klassifizierten '-' 3 erhöht und gleichzeitig die Gewichte anderer verringert. Übrigens wird im Standardcode von AdaBoost DecisionTree für diese schwache Diskriminatorklassifizierung verwendet.

Basierend auf dem Gewicht der wiederholten Klassifizierung werden wir einen starken Diskriminator bilden.

Extracted from Alexander Ihler's youtube video

Extracted from Alexander Ihler's youtube video

Standardcode

python

from sklearn.ensemble import AdaBoostClassifier

AdaBoostClassifier(base_estimator=None, n_estimators=50, learning_rate=1.0, algorithm='SAMME.R', random_state=None)

Beschreibung der Parameter in AdaBoost

- base_estimator

Ein Modell für maschinelles Lernen, das als schwacher Diskriminator verwendet wird. DecisionTreeClassifier wird standardmäßig verwendet, andere Modelle für maschinelles Lernen können jedoch durch Angabe angewendet werden.

- n_estimators

Geben Sie an, wie oft die Klassifizierung mit einem schwachen Diskriminator wiederholt werden soll. Wenn der starke Diskriminator jedoch zuvor 100% genau wird, endet er dort.

Die Vor- und Nachteile von AdaBoost.

- guter Punkt

Eine genaue Klassifizierung ist einfach, da mehrere schwache Klassifizierer kombiniert werden.

--Schlechter Punkt

Wie K nächste Nachbarn ist es auch anfällig für Rauschen (verschiedene Bezeichnungen werden an derselben Stelle gemischt) und Ausreißer (Ausreißer). Es ist leicht zu überlernen.

Zusammenfassung

Das Obige ist der Umriss von AdaBoost, soweit ich verstehen kann. Wir werden es täglich aktualisieren. Wenn Sie also etwas hinzufügen oder reparieren müssen, würden wir uns freuen, wenn Sie einen Kommentar abgeben könnten.

Recommended Posts