[PYTHON] Werfen Sie einen Blick auf die Verarbeitung von LightGBM Tuner

Einführung

Ankündigung unter PyData.Tokyo Ende September letzten Jahres ? ref = https://pydatatokyo.connpass.com/event/141272/presentation/) Der in) eingeführte LightGBMTuner wurde endlich implementiert.

- [Automatische Hyperparameteroptimierung mit Optuna-Erweiterung LightGBM Tuner \ | Preferred Networks Research & Development](https://tech.preferred.jp/ja/blog/hyperparameter-tuning-with-optuna-integration-lightgbm-tuner /)

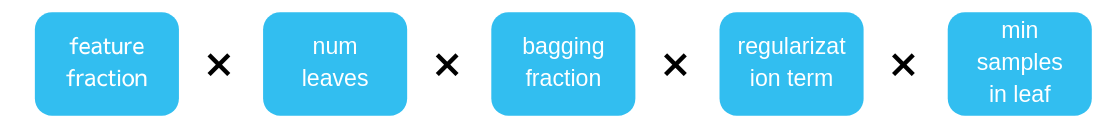

Die Parameter des Modells sind nicht auf LightGBM beschränkt, sondern nicht unabhängig, sondern interagieren miteinander. Daher kann eine höhere Genauigkeit erwartet werden, indem jeder Parameter zum Zeitpunkt der Parametereinstellung Schritt für Schritt eingestellt wird. Das Konzept besteht darin, die Parameter, die den größten Einfluss haben (was zu sein scheint), in der richtigen Reihenfolge abzustimmen.

Bestätigungsumgebung

- Windows10

- Python 3.7

- optuna 1.0.0

Inhalte verarbeiten

Die Implementierung ist hier

Die Implementierung ist hier

| No. | Inhalt | Methodenname | Parametername | Abstimmbereich | Anzahl von Versuchen |

|---|---|---|---|---|---|

| 1 | feature_fraction(Erstes Mal) | tune_feature_fraction() | feature_fraction | 0.4~1.0 | 7 mal |

| 2 | num leaves | tune_feature_fraction() | num leaves | 0~1(optuna.samplers.Verwenden Sie TPESampler) | 20 mal |

| 3 | bagging | tune_bagging() | bagging_fraction, bagging_freq | 0~1(optuna.samplers.Verwenden Sie TPESampler) | 10 mal |

| 4 | feature_fraction(Zweites Mal) | tune_feature_fraction_stage2() | feature_fraction | Erster optimaler Wert ± 0.08 Bereich (0.4~1.Werte außerhalb des Bereichs von 0 ausschließen) | 3~6 mal |

| 5 | regularization | tune_regularization_factors() | lambda_l1, lambda_l2 | 0~1(optuna.samplers.Verwenden Sie TPESampler) | 20 mal |

| 6 | min data in leaf | tune_min_data_in_leaf() | min_child_samples | 5, 10, 25, 50, 100 | 5 mal |

Die Punkte, an denen ich interessiert war, sind wie folgt.

--Was bewirkt die Optimierung von feature_fraction in zwei Schritten? --Ist es feature_fraction, bevor num geht?

- Die Abstimmung von lambda_l1 und lambda_l2 wird auf 0 zu 1 eingegrenzt (bisher war der Maximalwert 100, aber ist er zu breit?)

Wenn Sie den Optimierungsinhalt nach Ihren Wünschen ändern möchten, müssen Sie derzeit run () mit einem Affen-Patch implementieren.

Ergänzung

Wenn Sie die Bedeutung der Parameter nicht verstehen, verstehen Sie zunächst Ihre Gefühle unter dem folgenden Link. [Gefühle wichtiger Parameter in Gradientenverstärkung \ -nykergotos Blog](https://nykergoto.hatenablog.jp/entry/2019/03/29/%E5%8B%BE%E9%85%8D%E3%83 % 96% E3% 83% BC% E3% 82% B9% E3% 83% 86% E3% 82% A3% E3% 83% B3% E3% 82% B0% E3% 81% A7% E5% A4% A7 % E4% BA% 8B% E3% 81% AA% E3% 83% 91% E3% 83% A9% E3% 83% A1% E3% 83% BC% E3% 82% BF% E3% 81% AE% E6 % B0% 97% E6% 8C% 81% E3% 81% A1)

Recommended Posts