Führen Sie Apache-Spark auf IPython Notebook aus

Hintergrund

Ich interessiere mich für Big Data, Echtzeitanalyse, Data Mining, maschinelles Lernen und jeder schreibt und spricht auf unterhaltsame Weise über Blogs. Das klingt interessant. Es ist nur so, dass ich persönlich interessiert bin und recherchiere. Ich bin weniger als ein Bösewicht, also genieße ich, was ich auf dem nächsten Level mache.

- Wie im vorherigen Beitrag

Dinge die zu tun sind

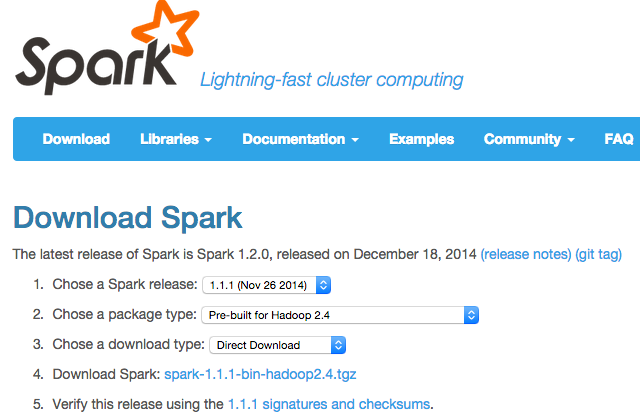

Sie müssen lediglich Apache-Spark einrichten, um es Ihrem IPython-Notebook zu verleihen. Wenn Sie es googeln, werden verschiedene Dinge herauskommen, aber ich möchte es für mich behalten, also machen Sie sich eine Notiz. Wie ich zuvor erfahren habe, wurde Spark 1.2.0 veröffentlicht, es ist also schon etwas alt. Aber ich denke es ist trotzdem dasselbe.

Annahme

- Lokal auf dem PC ausführen

- IPython Notebook kann gestartet werden

Umgebung

- Windows 7 / Mac OS X Yosemite / Ubuntu 14.11

- Alle 64bit

Verfahren

- Laden Sie Spark herunter und kopieren oder installieren Sie es irgendwo

Bei der Installation mit Homebrew scheint es sich in "/ usr / local / Cellar / apache-spark / 1.1.1" zu befinden.

-

Setzen Sie die Umgebungsvariable auf "SPARK_HOME"

export SPARK_HOME="Ordner, in dem der Funke entpackt wurde" -

Erstellen Sie ein IPython-Profil

$ ipython profile create pyspark -

Bearbeiten Sie das IPython-Umgebungsprofil

startup / 00-pyspark-setup.py#coding:utf-8 import os import sys os.environ['SPARK_HOME'] = '/usr/local/Cellar/apache-spark/1.1.1' spark_home = os.environ.get('SPARK_HOME', None) if not spark_home: raise ValueError('SPARK_HOME environment variable is not set') sys.path.insert(0, os.path.join(spark_home, 'libexec/python')) sys.path.insert(0, os.path.join(spark_home, 'libexec/python/lib/py4j-0.8.2.1-src.zip')) execfile(os.path.join(spark_home, 'libexec/python/pyspark/shell.py'))

In meiner Umgebung befindet sich die Konfigurationsdatei in ~ / .ipython / profile_pyspark. Schreiben wir py4j-0.8.2.1-src.zip neu, da dies von der Version abhängt.

In Windows war es meiner Meinung nach um den Benutzerordner.

-

Versuchen Sie zu starten

$ ipython notebook --profile=pyspark -

Es fühlt sich an, als würde sich etwas bewegen. Nein!

Referenz

http://blog.cloudera.com/blog/2014/08/how-to-use-ipython-notebook-with-apache-spark/

Recommended Posts